켄텍, 3차원 공간 추론 프롬프트 학습 기술 개발

이석주 교수팀, 110만개 파라미터로 대형모델 성능 구현

입력 : 2025. 10. 01(수) 11:00

본문 음성 듣기

가가

한국에너지공과대학교(켄텍)는 이석주 교수 연구팀이 비전-언어 모델(VLM)의 3차원 공간 추론을 가능하게 하는 경량 프롬프트 학습 기술을 개발했다고 1일 밝혔다.

연구팀은 이번 기술을 단일 카메라 기반의 깊이 추정 기법에 적용해, 인공지능(AI)의 공간 이해 능력을 크게 향상시키는 데 성공했다.

멀티모달 및 비전-언어 모델인 CLIP은 이미지와 텍스트를 동시에 이해하는 인공지능으로, 비전과 자연어처리를 융합하는 대표적인 모델이다. 예를 들어 ‘고양이’라는 단어를 입력하면 수많은 이미지 중 고양이가 등장하는 사진을 찾아내는 식이다. 그러나 기존 CLIP 모델은 거리나 깊이와 같은 기하학적 공간 이해에는 한계가 있었다.

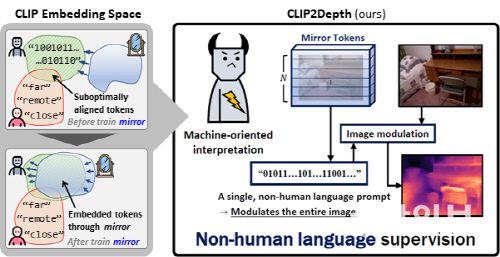

이석주 교수팀은 이러한 한계를 극복하기 위해 사람이 사용하는 언어 대신 기계가 이해하기에 최적화된 ‘비인간 언어 프롬프트(non-human language prompt)’를 새롭게 도입했다. 이 방식을 통해 AI가 단일 카메라로 촬영한 사진이나 영상만으로도 물체 간 거리와 깊이를 정밀하게 추론할 수 있도록 했다.

실험 결과 이번 기술은 약 110만개의 학습 파라미터만으로도 기존 대형 모델(3억개 이상)과 견줄 만한 성능을 보였다. 이는 필요한 파라미터 수를 약 300분의 1 수준으로 대폭 줄인 것으로, 모델의 경량화와 효율적 학습을 동시에 달성했다는 점에서 의미가 크다.

이석주 교수는 “이번 연구는 자율주행, 로봇 비전, 증강현실(AR) 등 경량화가 필수적인 공간 컴퓨팅 분야에서 폭넓게 활용될 수 있는 핵심 원천기술”이라며 “비전-언어 모델의 응용 범위를 3차원 공간으로 확장했다는 점에서 학문적·산업적 의의가 크다”고 말했다.

연구팀은 이번 기술을 단일 카메라 기반의 깊이 추정 기법에 적용해, 인공지능(AI)의 공간 이해 능력을 크게 향상시키는 데 성공했다.

멀티모달 및 비전-언어 모델인 CLIP은 이미지와 텍스트를 동시에 이해하는 인공지능으로, 비전과 자연어처리를 융합하는 대표적인 모델이다. 예를 들어 ‘고양이’라는 단어를 입력하면 수많은 이미지 중 고양이가 등장하는 사진을 찾아내는 식이다. 그러나 기존 CLIP 모델은 거리나 깊이와 같은 기하학적 공간 이해에는 한계가 있었다.

이석주 교수팀은 이러한 한계를 극복하기 위해 사람이 사용하는 언어 대신 기계가 이해하기에 최적화된 ‘비인간 언어 프롬프트(non-human language prompt)’를 새롭게 도입했다. 이 방식을 통해 AI가 단일 카메라로 촬영한 사진이나 영상만으로도 물체 간 거리와 깊이를 정밀하게 추론할 수 있도록 했다.

실험 결과 이번 기술은 약 110만개의 학습 파라미터만으로도 기존 대형 모델(3억개 이상)과 견줄 만한 성능을 보였다. 이는 필요한 파라미터 수를 약 300분의 1 수준으로 대폭 줄인 것으로, 모델의 경량화와 효율적 학습을 동시에 달성했다는 점에서 의미가 크다.

이석주 교수는 “이번 연구는 자율주행, 로봇 비전, 증강현실(AR) 등 경량화가 필수적인 공간 컴퓨팅 분야에서 폭넓게 활용될 수 있는 핵심 원천기술”이라며 “비전-언어 모델의 응용 범위를 3차원 공간으로 확장했다는 점에서 학문적·산업적 의의가 크다”고 말했다.

이승홍 기자 photo25@gwangnam.co.kr